杨冰

杨冰

阅读量:382

2025年12月,一场引发医疗界、法律界与科技界高度关注的庭审在北京市某区人民法院拉开帷幕。这起全国首例“AI临床决策支持系统(AI-DSS)医疗损害责任案”的开庭,标志着人工智能深度介入医疗决策后,法律责任界定进入实质性探索阶段。案件核心争议直指AI算法在用药剂量决策中的过错认定,其判决结果或将重塑医疗AI行业的责任边界。

2025年6月,58岁的糖尿病患者李某因血糖控制不佳入住某三甲医院内分泌科。主治医生在诊疗过程中启用了该院新引入的AI-DSS系统,该系统通过整合患者电子病历、检验数据、基因检测结果及全球全新医学文献,为医生提供个性化用药建议。在输入患者体重、肾功能指标等参数后,AI系统推荐了超出常规剂量20%的胰岛素方案,并标注“基于患者基因型对药物敏感性增强,建议调整剂量”。主治医生未进一步核实算法逻辑,直接采纳建议调整用药。

然而,用药后李某出现严重低血糖昏迷,虽经抢救脱离生命危险,但因脑部缺氧导致长期性认知障碍。经第三方医疗鉴定机构分析,AI系统在剂量计算中存在双重漏洞:其一,未充分考量患者同时服用的降压药与胰岛素的协同作用,导致药物叠加效应被低估;其二,基因检测数据解读模型存在偏差,患者实际对胰岛素的代谢能力并未显著高于常人。鉴定结论明确指出:“AI系统过错参与度为60%,医生未履行审慎审核义务的过错参与度为40%。”

这起案件的审理突破了传统医疗纠纷的二元责任框架,将AI开发者、医疗机构、医生三方卷入复杂的责任漩涡。

涉案AI系统的研发方——某科技公司主张,其算法已通过国家药监局创新医疗器械审批,并符合《人工智能医疗器械注册审查指导原则》中“可解释性”要求。公司律师在庭审中出示了算法逻辑流程图,强调系统在剂量决策中纳入了127项变量,并采用蒙特卡洛模拟进行风险评估。然而,当法官要求提供具体参数权重分配模型时,公司以“商业秘密”为由拒绝披露核心代码,引发患者家属强烈质疑:“如果算法连阳光都照不进去,如何保证不会成为逃避责任的挡箭牌?”

医院方辩称,其已建立AI临床应用管理制度,要求医生对AI建议进行“双盲复核”(即由两名医生独立评估)。但调查发现,涉事科室为追求诊疗效率,实际执行中仅由一名医生快速浏览AI报告后签字确认。更关键的是,医院采购AI系统时未要求厂商提供算法训练数据集的脱敏样本,导致系统可能因数据偏差(如训练集中欧美患者占比过高)而误判国内人群药物代谢特征。

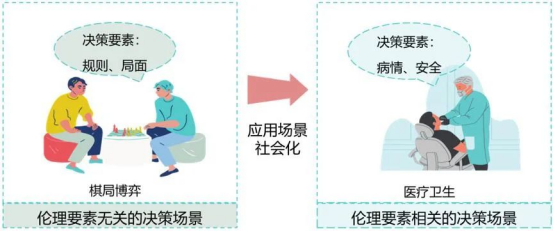

主治医生在庭上陈述:“AI报告标注了‘建议调整剂量’,并附有3篇支持性文献,我基于对系统既往准确率的信任(该科室使用该系统半年内诊断符合率达92%)选择了采纳。”这一辩词揭示出医疗AI应用中的深层矛盾:当算法以“科学权威”姿态介入诊疗时,医生的专业判断力是否正在被技术异化?国内医学科学院伦理专家指出:“医学的本质是‘人学’,AI可以处理数据,但无法理解患者对治疗的恐惧、对副作用的耐受度等人文因素。”

案件曝光后,医疗AI行业迎来剧烈震荡。资本层面,A股医疗信息化板块单日蒸发超200亿元,多家企业紧急暂停IPO进程;监管层面,国家卫健委连夜发布《医疗AI临床应用风险管控指南》,明确要求:

算法备案制:所有高风险医疗AI系统需向省级卫健部门提交算法逻辑摘要、训练数据来源及验证报告;

双医师审核制:AI辅助诊断结果必须经两名副主任医师以上职称医生独立确认后方可执行;

责任保险强制化:医疗机构使用医疗AI需购买专项责任险,单例最高赔付额提升至800万元。

企业端则加速技术迭代。涉案科技公司宣布投入5亿元研发“可解释性增强模块”,通过自然语言生成技术,将算法决策过程转化为医生可理解的逻辑链条。例如,系统在推荐剂量时会同步说明:“根据患者CYP2C9基因型,药物代谢速率预计加快15%,故建议减少初始剂量至常规值的85%。”

对比国际经验,我国医疗AI责任界定面临独特挑战。欧盟《AI责任指令》采用“过错推定”原则,要求开发者自证算法无缺陷;美国FDA则通过“算法影响评估”制度,强制企业公开模型训练数据的种族、年龄分布。而我国现有法律体系下,《民法典》第1223条仅笼统规定“药品、医疗器械缺陷造成损害的,被侵权人可向生产者、销售者请求赔偿”,未明确AI系统的法律主体地位。

清华大学法学院教授建议,可借鉴航空业“黑匣子”制度,要求医疗AI系统实时记录决策数据链,在纠纷发生时由第三方机构调取分析。同时,建立“算法过错”与“医疗过错”的区分认定标准:“若AI因数据偏差或逻辑错误导致决策失误,属产品缺陷;若医生未履行审核义务,则属医疗过失。”

这起案件的终极判决或许尚需时日,但其引发的思考已超越个案范畴。当AI开始主导用药剂量、手术方案甚至生死决策时,人类必须回答三个根本性问题:

技术边界:哪些医疗决策应严格保留人类最终裁定权?例如,终末期患者的姑息治疗是否适合由算法决定?

责任重构:在“开发者-系统-医生-患者”的复杂链条中,如何建立公平的风险分担机制?

伦理嵌入:如何通过技术设计(如价值对齐算法)确保AI决策符合医学伦理基本原则?

正如庭审中患者家属的泣诉:“我们不是反对科技进步,但当算法开始决定生死时,它必须比人类医生更谨慎、更透明、更可追溯。”这或许正是医疗AI走向成熟必须跨越的门槛——在追求效率的同时,始终守护生命不可量化的价值。

寻找优质医疗资源 伴您走上康复之路

寻找优质医疗资源 伴您走上康复之路